Теория:

Измерить какую-нибудь величину — это значит сравнить её с однородной величиной, принятой за единицу.

Всякое измерение может быть выполнено с большей или меньшей точностью.

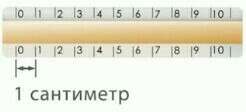

В качестве примера рассмотрим измерение длины бруска линейкой с сантиметровыми делениями.(картинка 1)

Вначале определим цену деления линейки. Она будет равна 1 см. Если левый конец бруска совместить с нулевым штрихом, то правый будет находиться между 9 и 10 штрихами, но ближе к 10. Какое же из этих двух значений следует принять за длину бруска? Очевидно, то, которое ближе к истинному значению, т.е. 10 см. Считая, что длина бруска 10 см, мы допустим неточность, так как брусок чуть короче 10 см.

Погрешность измерения не может быть больше цены деления измерительного прибора. В нашем случае погрешность измерения бруска не превышает 1 см. Если такая точность измерений нас не устраивает, то можно произвести измерения с большей точностью. Но тогда придётся взять масштабную линейку с миллиметровыми делениями, т.е. с ценой деления 1 мм. В этом случае длина бруска окажется равной 9,8 см.(картинка 2)

В физике допускаемую при измерении неточность называют погрешностью измерений.

Для более точных измерений можно воспользоваться штангенциркулем с ценой деления 0,1 мм или 0,05 мм. (картинка 3)

Из этого примера видно, что точность измерений зависит от цены деления шкалы прибора.

Чем меньше цена деления, тем больше точность измерения.

Точность измерения зависит от правильного применения измерительного прибора, расположения глаз при отсчёте по прибору.

Вследствие несовершенства измерительных приборов и несовершенства в развитии наших органов чувств, при любом измерении получаются лишь приближённые значения, несколько бóльшие или меньшие истинного значения измеряемой величины.

Во время выполнения лабораторных работ или просто измерений следует считать, что:

Погрешность измерений равна половине цены деления шкалы измерительного прибора.

При записи величин (с учётом погрешности) следует пользоваться формулой: A=a±Δa,

где A — измеряемая величина, a — результат измерений, Δa — погрешность измерений (Δ — греческая буква «дельта»).